Was ist Perzeptron? Einfach erklärt!

Ein Perzeptron – im Englischen Perceptron – bezeichnet das wohl bekannteste Grundmodell künstlicher Neuronen. Ähnlich einer biologischen neuronalen Nervenzelle erhält der künstliche Knoten mehrere Eingangssignale, multipliziert sie mit gewichteten Parametern und entscheidet anschließend mithilfe einer Aktivierungsfunktion, ob eine Ausgabe erzeugt wird. Auf diese Weise lassen sich Datenpunkte in zwei Klassen sortieren; die Klassifikation gelingt also, sobald die Daten linear trennbar sind.

Das Konzept wurde 1957 von Frank Rosenblatt vorgestellt und galt damals als großer Schritt für die frühe Mustererkennung. Schon ein einlagiges Netz zeigte die Fähigkeit, elementare Vorhersagen über simple Datensätze zu treffen. Erst später erkannte man, dass komplexere Aufgaben – etwa das berühmte XOR-Problem – ein mehrlagiges Netz erfordern. Trotz anfänglicher Kritik entwickelte sich das Modell zum Fundament moderner neuronaler Systeme im maschinellen Lernen.

Die biologische Idee hinter dem Modell

Ein Perzeptron abstrahiert eine neuronale Nervenzelle. Eingangswerte entsprechen den Synapsen, Gewichte modellieren ihre Stärke. Der ausgelöste Impuls entsteht, sobald der interne Schwellenwert überschritten wird. Dieser biologische Vergleich macht das Konzept anschaulich und verdeutlicht, warum eine Aktivierung meist als Stufenfunktion oder Treppenfunktion beschrieben wird.

Eingaben, Gewichte und Schwellwert

Jeder Knoten sammelt Eingabewerte in Form eines Vektors x. Für jede Komponente existiert ein Gewicht w. Nach der gewichteten Summation w·x wird der Schwellwert (oft Bias genannt) subtrahiert. Genau diese Differenz entscheidet, ob die Aktivierungsfunktion feuert. Auf diese Weise entsteht ein linearer Trenner, der Datenwerte durch eine Entscheidungsgrenze separierbar hält.

Aktivierungsfunktion im Detail

Frühe Modelle setzen auf die Stufenfunktion – im Digitalbereich praktisch, da nur 0 oder 1 ausgegeben wird. Moderne Varianten ersetzen sie durch Sigmoid, ReLU oder einer Treppenfunktion mit Glättung, wodurch Ableitungen existieren. Gerade für Backpropagation und die Kettenregel wird eine kontinuierliche Aktivierung benötigt, damit der Lernprozess stabile Gradienten liefern kann.

Lernregel, Lernrate und Epoche

Die klassische Lernregel von Rosenblatt verändert Gewichte gemäß der Differenz zwischen gewünschter und aktueller Ausgabe. Pro Epoche, also nach jedem Durchlauf durch alle Trainingsdaten, werden die Gewichte angepasst. Die Lernrate steuert dabei, wie stark eine Wiederholung korrigiert wird. Ein zu hoher Wert führt oft zu Overfitting oder Divergenz, ein zu niedriger verlangsamt Fortschritte.

Die Geschichte von Rosenblatt bis heute

Rosenblatt kombinierte McCullochs frühe Ideen mit statistischer Lerntheorie und schuf damit den Algorithmus, der als Perzeptron in die Literatur einging. Nach anfänglicher Euphorie setzte eine Pause ein, weil das Modell XOR nicht lösen konnte. Die Wiederentdeckung kam in den 1980ern, als mehrschichtiges Lernen und Backpropagation gezeigt wurden. Heute findet sich das Konzept in fast jedem Lehrbuch über maschinelle Lernalgorithmen, denn selbst tiefe Netze bestehen letztlich aus einer großen Zahl erweiterter Perzeptren.

Mathematisches Grundgerüst

Formal ist das Perzeptron eine Funktion f(x) = ϕ(w·x − θ). Dabei steht θ für den Schwellenwert, w für den Gewichtsvektor und ϕ für die Aktivierungsfunktion. Die Entscheidungsebene ist eine Hyperebene, die Datenpunkte in zwei Hälften teilt. Sind die Trainingspunkte linear trennbar, so beweist die Perzeptron-Konvergenz, dass endliche Iterationen ausreichen, um korrekte Klassifizierung zu erreichen.

Das mathematische Resultat zeigt auch, weshalb ein einlagiges Netz komplexe Muster nur dann erkennt, wenn diese bereits separierbar sind. Das klassische Perzeptron wird hier nur dann aktiv, wenn die in einer inneren Schicht aggregierten Signale den festgelegten Wert übersteigen und somit die Eingabewerte eine eindeutige Richtung vorgeben.

Training mit Lernregel und Lernrate

Der Lernalgorithmus startet mit zufälligen Gewichten. Für jedes Datenpaar (x, y) wird zunächst eine Vorhersage erzeugt. Liegt eine Fehlklassifikation vor, addiert oder subtrahiert die Lernregel den Vektor x, skaliert mit Lernrate, zu w. Dieses Verfahren verschiebt die Entscheidungsgrenze in Richtung des fehlerhaften Datenobjekts. Mehrere Epochen über das gesamte Trainingsdaten-Set reduzieren den Gesamtfehler.

In einem mehrlagigen Szenario übernimmt Backpropagation das Aktualisieren, wobei die Kettenregel die Gradienten von der Ausgabe zu jedem Knoten zurückleitet. Auf diese Weise lässt sich nicht nur klassifizieren, sondern auch abstrakte Relationen erlernen; in tiefen neuronalen Architekturen können die Modelle das Gelernte weiter erlernen, sobald eine hinreichende Vielfalt an Beispielen vorhanden ist und die Verbindungen stabil bleiben.

Grenzen: XOR, trennbar oder separierbar?

Die berühmteste Schwachstelle ist das XOR-Problem. Zwei Klassen sind hier nicht durch eine einzige Gerade trennbar. Ein einlagiges Modell versagt, obwohl es mathematisch korrekt arbeitet. Erst ein mehrschichtiges Netzwerk mit mindestens einer verborgenen Schicht kann die nicht-lineare Trennung abbilden. Damit wird deutlich, dass die Fähigkeit eines Netzes direkt von seiner Architektur abhängt. Zu viele Parameter bringen jedoch eine zu starke Anpassung: Das Netz merkt sich die Datensätze, anstatt deren Muster zu erlernen, wodurch Vorhersagen für unbekannte Datenwerte leiden.

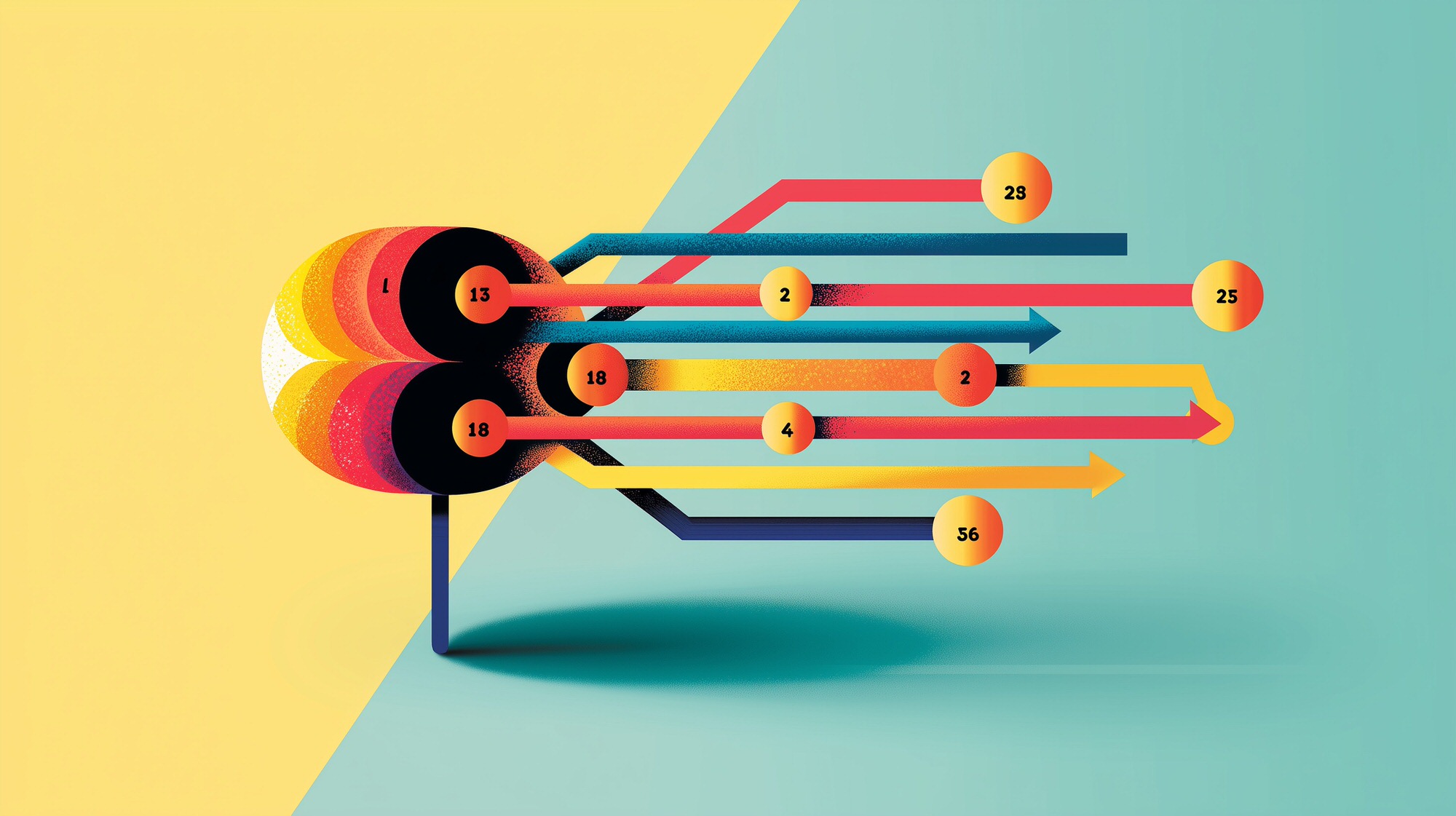

Mehrschichtiges Perzeptron und Backpropagation

Ein mehrschichtiges Netzwerk reiht mehrere Perzeptren aneinander. Jede Schicht liefert Aktivierungen als Eingaben für die nächste. Das Training erfolgt mit Backpropagation: Die Differenz zwischen Ziel und Ausgabe läuft rückwärts, die Kettenregel berechnet partielle Ableitungen, und jede gewichtete Verbindung erhält ein Update. Auf diese Weise verbessert jede Iteration die Gesamtleistung. Für stabile Verbesserungen empfiehlt sich eine angepasste Lernrate, oft dynamisch reduziert, sobald der Fehler kaum noch fällt.

Praktische Tipps gegen Overfitting und für stetige Fortschritte

Regulierungsmethoden wie Dropout, frühzeitiges Stoppen nach wenigen Epochen oder L-2-Gewichtsstrafe begrenzen Overfitting. Hilfreich ist zudem, zusätzliche Trainingsdaten zu sammeln oder durch Datenaugmentation künstlich zu erzeugen. Ein Validierungssatz liefert eine Aussage darüber, ob das Modell generalisiert. Steigt der Fehler dort, während der Trainingsfehler fällt, bricht man den Lernprozess besser ab. Kleine Mini-Batches glätten Rauschspitzen in der Gradienten-Schätzung und sorgen so für gleichmäßige Abläufe.

Ein letzter Blick auf die Praxis verdeutlicht, wie jede zusätzliche Schicht einen neuen Raum binärer Abbildungen öffnet. In vielen Anwendungen wird das Perceptron heute gemeinsam mit anderen neuronalen Komponenten trainiert, um Eingangssignale in Echtzeit zu klassifizieren. Dabei führt schon eine überschaubare Zahl von Parametern zu robusten Entscheidungen, wenn der Datenstrom klar binären Charakter besitzt.